随着计算机视觉技术的发展, 该领域中的目标检测技术越来越多地应用于实际生活中. Logo作为一种识别和传达信息的视觉图形, 是人们在长期生活和实践中形成的视觉化表达方式. 不管是商品还是企业或是政府部门等, 都有专属的标志Logo. Logo的检测有巨大的应用前景, 是计算机视觉中的重要任务. 目前对于Logo检测的研究已有不少[1], 例如文献[2]中基于SIFT特征进行匹配的方法来检索带有特定Logo的图像. 文献[3]首次提出了基于全局不变特征的Logo检测与识别算法. 以及基于前面的成果, 文献[4]尝试利用一些约束条件, 如圆和点或是圆和线的关系等, 并且利用其中的文字信息进行更为精确的识别. 以及文献[5]所做的主要针对文本图片中Logo目标的检测研究.

Logo检测任务可看成是具一般性的目标检测任务. 在卷积神经网络(CNN)广泛应用于物体检测以前, 以往的方法通常是通过人工选定特征描述符的传统检测手段, 这些方法有很多的局限性, 在实际中得不到很好的应用. 并且这类传统的检测方法已达到了瓶颈. 然而随着卷积网络在目标检测技术方面的发展, 各类研究成果被不断提出. 如文献[6]中的R-CNN采用选择性搜索来查找包含高概率对象的预测框, 使用卷积层提取每个预测框的高维特征, 由支持向量机(SVM)确定目标类别. 但R-CNN中因为每个预测框都有一些重叠, 存在大量重复计算的缺点. 为了缓解这个问题, 文献[7]提出Fast R-CNN网络, 通过引入一个感兴趣区域池化层(ROI Pooling)来共享特征的计算. 该网络使用整个图像作为输入来提取全局特征图, 然后感兴趣区域池化层从它们中提取每个预测框的固定长度特征. 然而, Fast R-CNN因采用选择性搜索导致过程分离, 限制了检测速度进一步提升. 因此, 文献[8]提出了区域提名网络(RPN)以进一步提高检测速度, 相应的方法称为Faster R-CNN. 虽然RPN依赖于几百个预测框就能达到和Fast R-CNN上千个预测框相同的检测效果. 但是在分辨率低的目标的检测效果上, Faster R-CNN相较于Fast R-CNN是有所下降的. 但是Faster R-CNN在检测精度和检测速度上取得了一个很好的平衡. 此外, 在上述的检测方法中都应用了边框回归方法以提高检测精度[6–8].

除了上面提到的方法之外, 还有一类目标检测方法不采用区域提名方法寻找预测框. 如文献[9]中提到的YOLO网络, 它们的特点是直接从整个特征图上选取预测框和预测概率. 并且它在检测时加入全局上下文信息, 很少在背景类的分类中出错, 并具有良好的泛化能力. 但是, YOLO对物体的比例非常敏感. 它通过在每个单元格上滑动来预测目标框. 如果单元格太小, 则无法提高速度; 如果单元格太大, 则难以检测到物体. 为了解决这些弱点, 文献[10]中提到的SSD网络在每层卷积之后添加了池化操作, 逐层递减特征尺度以形成特征图金字塔. 然后, 在每层特征图上的单元格滑窗提取预测框. 这不仅改善了YOLO在预测框选择上的限制, 还保证了速度.

目前, 已提出的各类方法基本上都偏适用于中大型目标的检测, 小目标的检测效果并不理想, 这里提到的小目标指的是分辨率低的目标. 小目标在图像中往往占据很小的一部分, 通过卷积之后它的特征会变得更小, 特征的分辨率也就更低. 这样的目标特征不明显而难以正确检测, 而相比之下中大型的目标卷积后的高分辨率的特征更加明显所以好检测. 虽然不少学者针对小目标检测性能的改善要求, 已提出相应的解决办法[11–13]. 但这些方法基本上都是通过获取多尺度特征来改善小物体的检测性能. 这类方法不仅大大降低了检测速度, 而且不能保证提取的特征足以有效检测小物体.

为此, 我们提出一种设想: 如果能基于现有的对中大型目标已达到良好检测效果的网络框架, 通过改进, 使其能将小目标的特征映射成具有相似特征分布的高分辨率的大目标的特征, 那么就能提升Logo的检测性能. 基于这一考虑, 本文针对现有的各类方法的分析结果和Logo目标的特点, 选取Faster R-CNN作为改进框架. Faster R-CNN对中大型的目标具有良好的检测效果, 但对小目标的检测效果不佳[14,15]. 我们将生成对抗模型应用到Faster R-CNN的网络架构中, 通过对抗训练方式, 使网络具备将低分辨率的特征图映射到高分辨率的特征图的能力, 从而提高整个网络的检测性能.

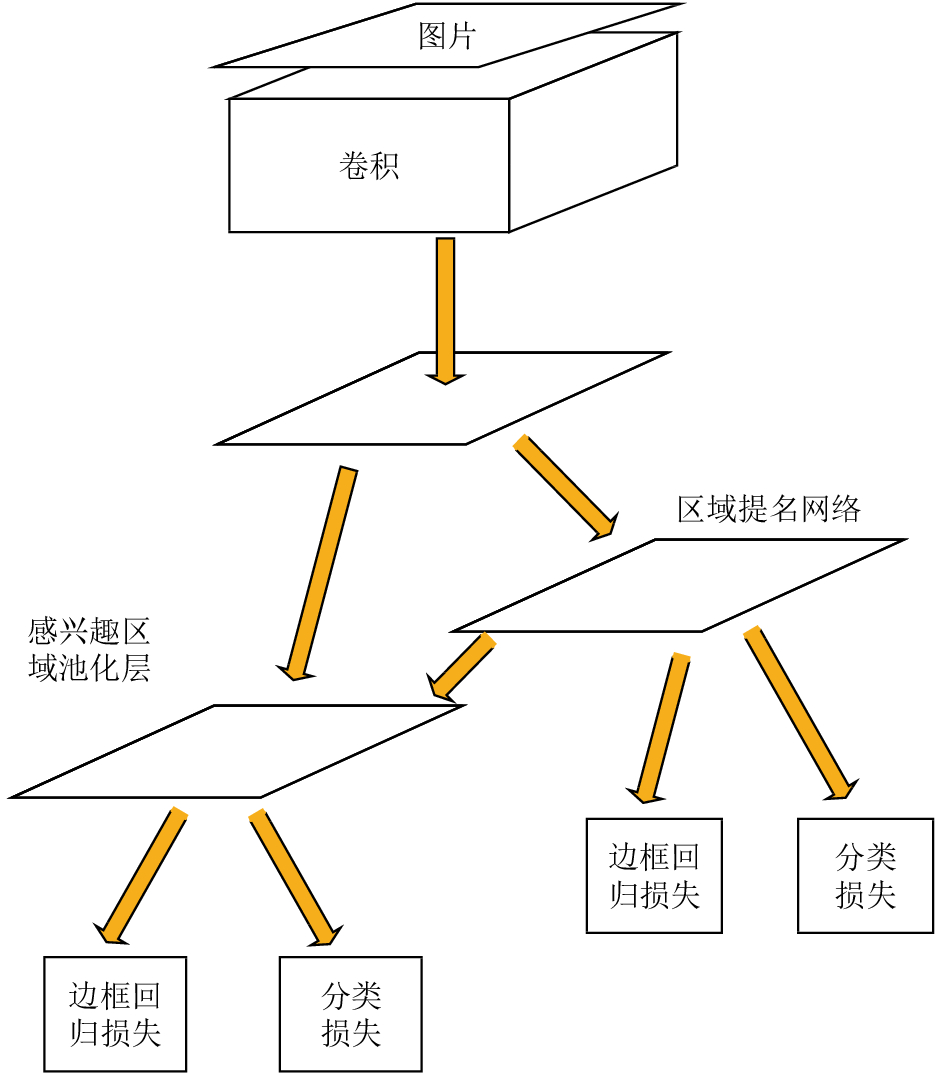

1 改进的Faster R-CNN网络结构 1.1 经典的Faster R-CNN的网络模型Faster R-CNN是经过R-CNN和Fast R-CNN的积淀, 由Ross B. Girshick在2016年提出的. 它在Fast R-CNN的基础上引入区域提名网络(RPN)来提取预测框, 解决了采用选择性搜索导致的过程分离问题, 并通过交替训练使RPN和Fast R-CNN网络共享参数. 因此在结构上, Faster R-CNN已经将特征提取、预测框提取、边框回归(bounding box regression)、分类都整合在了一个网络中, 使得综合性能有较大提高, 尤其在检测速度方面. Faster R-CNN网络流程图如图1所示.

Faster R-CNN的结构主要包含卷积/池化、RPN网络、感兴趣区域池化层和分类器. 首先由卷积/池化部分提取图片的特征图, 接着由RPN网络提取候选框, 然后将候选框和特征图输入感兴趣区域池化层提取各侯选框的特征, 最后由分类器实现目标识别与定位.

|

图 1 经典的Faster R-CNN的检测流程图 |

RPN网络是Faster R-CNN的核心部分, 类似于以往目标检测中的选择性搜索的作用, 通过卷积神经网络来选取候选框. 由于图片中的目标的尺度和宽高比不一, 需要多种类型的窗口. 因此, RPN采用anchor机制, 即设定一个基准窗口大小, 按照(8,16,32)三种倍数和(0.5,1,2)三种比例得到9种尺度的窗口. 通过在输入的特征图上滑动窗口, 即可得到关于这张图片的目标预测框. RPN网络的输出是一个包含二类分类和边框回归的多任务模型. 二类分类通过Softmax输出预测框属于前景类还是背景类, 边框回归则是用于计算预测框的偏移量, 以便获得更加准确的定位. 最后, 综合预测框的概率和偏移量, 运用非极大值抑制(NMS)去除太小和超出边界的预测框, 然后将预测框送入完全连接层做进一步的分类和边框回归.

RPN网络的提出虽然帮助Faster R-CNN加快了速度, 但是由于RPN只依赖几百个预测框选取目标位置, 在目标的召回率上必定有所下降. 并且RPN网络的窗口类型有限难以满足多种尺度目标的检测需求. 鉴于目前大部分数据集中的目标尺度适中, 小型目标偏少, 所以Faster R-CNN在窗口的设置上偏于适应中大型目标的检测, 对于小目标的检测效果并不理想.

1.2 对抗生成网络模型(GANs)生成对抗网络(GANs)[16]是用于学习生成模型的框架, 由Ian Goodfellow于2014年首次提出. 它并不一定要以卷积网络构成, 但已提出的各种用途的生成对抗网络基本上都是卷积网络. Mathieu等人[17]和Dentonet等人[18]采用了GANs实现图像生成. 在文献[19]和文献[20]中, GANs是分别用于学习从一个流形到另一个流形的风格转移和修复的映射. 除此之外, 使用GANs进行无监督表征学习在文献[21]中被提出. 文献[22]中提出将GANs应用到超分辨图像.

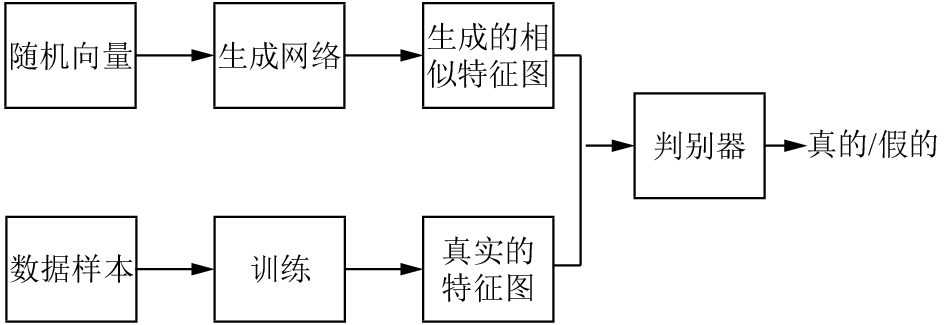

生成对抗网络是由竞争的两个神经网络模型组成. 一个将噪声作为输入并生成样本, 所以称为生成器, 用G来表示. 另一个模型称为判别器, 用D来表示. 它的输入有两种, 一种是生成器生成的样本, 另一种是训练数据中的真实样本. 生成器的目的是生成能欺骗判别器的样本, 判别器的目的的是能够区分样本是生成的还是真实的样本. 这两个网络的训练过程是对抗学习, 并且两个网络同时训练, 最后当生成器和判别器的损失函数达到一个平衡(纳什平衡)时, 即G可以生成足以“以假乱真”的样本G(z). 对于D来说, 它难以判定G生成的图片究竟是不是真实的, 因此D(G(z))=0.5. 生成对抗网络模型的流程图如图2所示.

|

图 2 生成对抗网络流程图 |

1.3 改进的Faster R-CNN

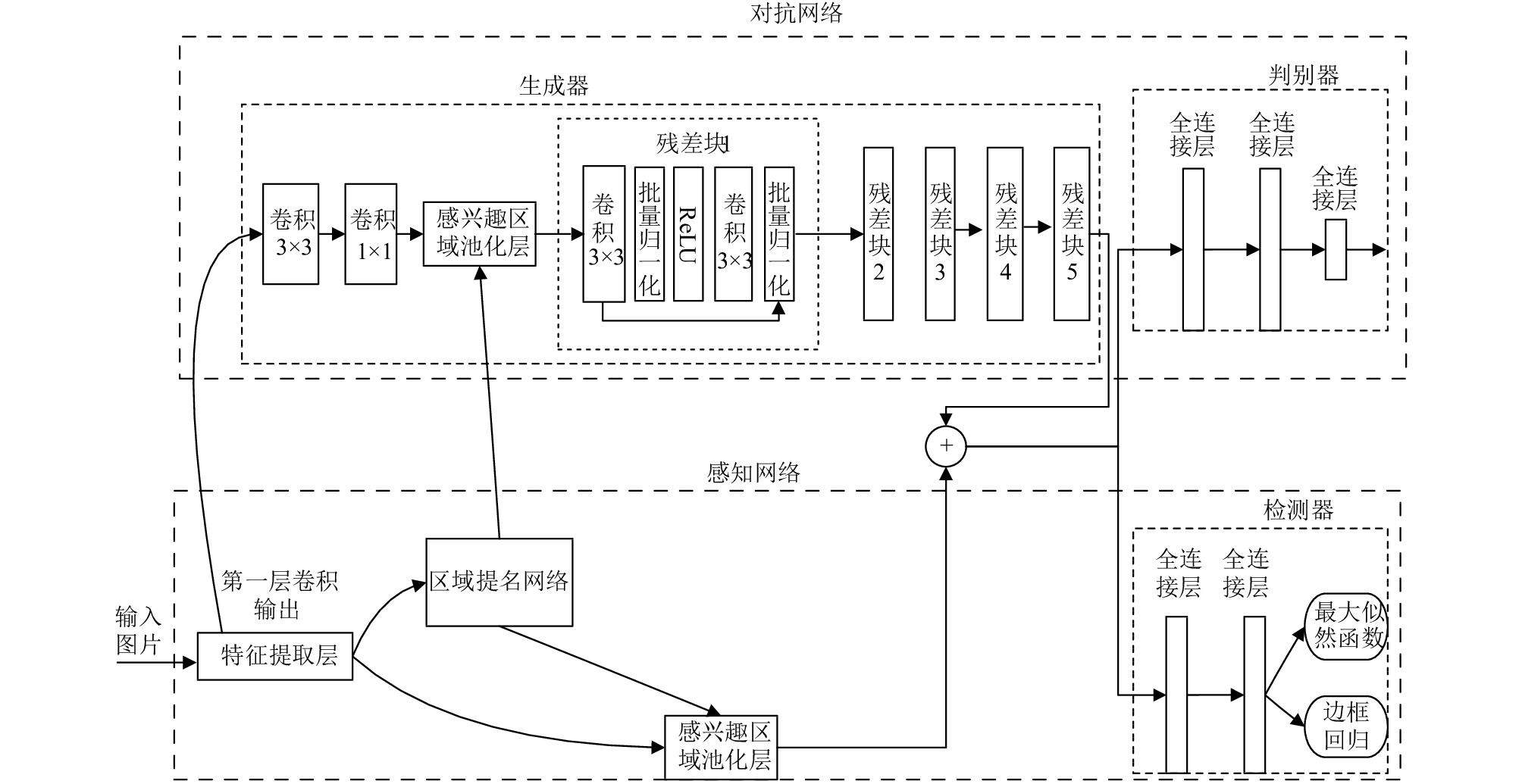

本文基于Faster R-CNN网络对中大型目标已有良好的检测效果而对小目标的检测效果不佳的情况, 根据生成对抗网络可生成高分辨率图像的特性, 提出了一种新的检测器. 网络的具体结构如图3所示, 整个网络可以分成两个子网络. 上层子网络是由生成器和判别器组成的对抗网络, 用于为低分辨率目标生成适当的特征偏差. 下层子网络是由Faster R-CNN框架构成的感知网络, 用于目标分类和回归.

对抗网络中, 生成器以Faster R-CNN的第一层卷积输出的特征作为输入, 然后进行3×3的卷积和1×1的卷积处理. 这两次卷积处理的主要目的是为了与感知网络五层3×3的卷积的最终输出的256个特征通道保持一致. 五个残差块依次连接作为生成器的主干部分, 用于学习低分辨目标特征和高分辨目标率特征的的特征偏差, 再与下层的Faster R-CNN中的五层卷积得到的特征按像素相加得到高分辨率的特征. 每个残差块都是由3×3的卷积层, 批量规范化层以及ReLU激活函数层组成. 判别器的输入包括生成的高分辨目标特征和真实的高分辨目标特征两类, 生成的高分辨目标特征作为负样本, 真实的高分辨率目标特征作为正样本, 通过为两种样本安排不同的标记帮助判别器学习区分真伪数据.

|

图 3 改进的Faster R-CNN网络框架图 |

感知网络结构采用的是Faster R-CNN的检测框架, 以五层卷积进行特征提取. RPN网络在特征图上选取预测框后会送入检测器做进一步的分类和回归.

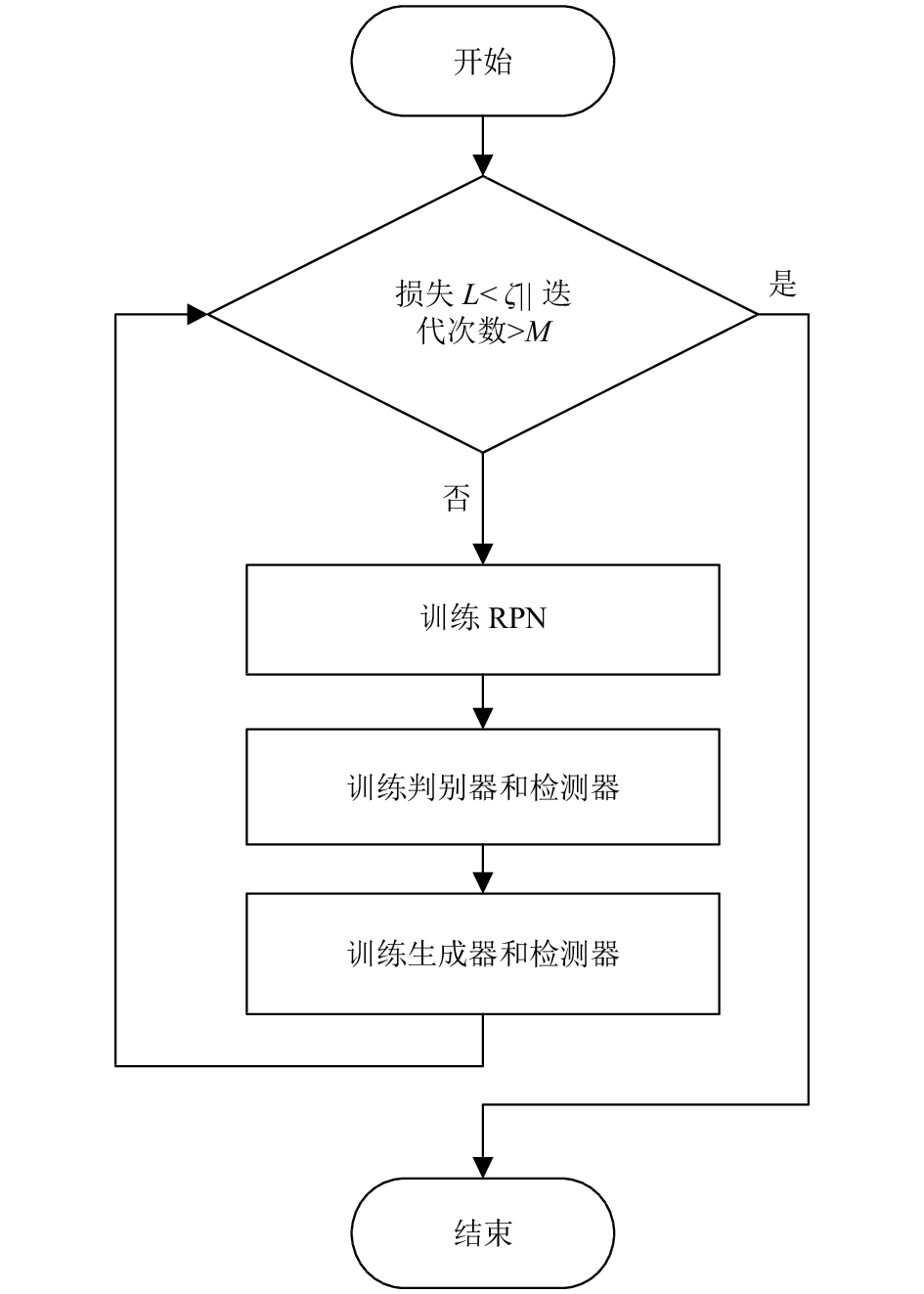

2 改进的Faster R-CNN的训练过程整个网络的训练过程是不断交替的迭代过程. 每次迭代的训练过程如图4所示, 可分为如下三步:

1)训练RPN网络提取目标预测框.

2)训练判别器和检测器: 用高分辨的图像训练感知网络和判别器, 判别器利用判别损失Ldis反向调参判别网络, 感知网络利用感知损失Lp反向调参感知网络, 相应的损失表达式将在下面具体介绍.

3)判别器参数保持不变, 训练生成器和检测器: 用低分辨率的图像一起训练生成器和感知网络, 生成器会为低分辨率的目标生成合适的特征偏差, 与感知网络卷积后的目标特征按像素级相加得到生成的高分辨率的目标特征, 送入判别器和检测器. 此时因为生成器和判别器的训练过程是相互对抗的, 为了提高生成器的生成能力, 判别网络不做反向调参. 我们利用生成损失Lg和感知损失Lp一起监督整个高分辨率特征生成过程, 相应的损失函数为L=w1Lg+w2Lc. 其中, w1, w2是两个权重. 在这里我们将它们设置为1.

交替训练过程中, 生成器不断学习为低分辨的目标特征生成合适的特征偏差, 判别器不断学习区分生成的高分辨率特征和真实的高分辨率特征. 通过迭代训练会不断加强生成器和判别器的能力, 从而提高低分辨率的小目标的检测准确率.

2.1 对抗损失对于生成器, 我们的目标是训练一个生成函数G将fs转换成fl来欺骗判别器D. 这里fl和fs分别表示高分辨率的目标特征和相对应的低分辨率的目标特征. 然而, 生成器可能很难从fs中包含的有限信息中学习直接生成高分辨率的特征. 因此, 从感知网络的低层卷积中引入特征f到生成网络中来学习高分辨率特征和相对应的低分辨特征之间的特征偏差, 通过和Faster R-CNN卷积后的特征做像素级的叠加生成最终的高分辨特征. 在本文的设计中, 我们的目标是改善小目标的检测性能, 所以只需为低分辨率的目标特征做高分辨率特征映射. 对于高分辨率目标我们需要生成器生成的特征偏差为零. 因此, 相应的生成损失函数定义如下:

| $ {L_g} = - \log D({f_s} + G({f_s}|f)) $ | (1) |

|

图 4 改进的Faster R-CNN的训练流程图 |

对于判别器, 对于输入的真实的高分辨率特征和生成的高分辨率特征, 需要通过判别损失来反向调参, 使判别器通过训练对于输入的真伪数据学习区分. 显然当Ldis足够小时, 判别器将能够区分所生成的特征与真实的特征之间的差异. 最后, 判别损失可以描述为:

| $ {L_{dis}} = - \log D({f_l}) - \log (1 - D({f_s}|f)) $ | (2) |

当对抗训练达到平衡时, 即判别网络无法区分输入是真实特征图还是生成特征图时, 此时的生成器已经可以为低分辨率的小目标生成以假乱真的高分辨特征, 生成器的训练可以停止.

2.2 感知损失在感知网络训练过程中, 从特征图提取的每个预测框被送入检测器, 得到两类输出. 第一个输出层由softmax回归计算n+1个类中每个预测框的概率p=(p0, p1,…, pn). 第二个输出层计算预测框坐标rn=(rnx, rny, rnw, rnh). 然后, 使用公式(3)定义的多任务损失函数Lp对预测框的类型和坐标进行回归计算, 同时计算得到预测框的坐标偏移.

| $ {L_p} = {L_{cls}}(p,g) + \lambda [g \ge 1]{L_{loc}}({r^g},r) $ | (3) |

其中, Lcls(p, g)=–log pg是真实类别g的对数损失. Lloc是边界回归损失函数, 定义如下:

| $ {L_{loc}}\left( {{r^g},r} \right) = \sum\limits_{i \in \left( {x,y,w,h} \right)} {{S_{L1}}\left( {r_i^g - {r_i}} \right)} $ | (4) |

其中, SL1是平滑损失函数, 定义如下.

| $ S_{L1} = \left\{ \begin{array}{l} 0.5{x^{_{^2}}},\;\;\;\;|x| < 1\\ |x| - 0.5,\;\;\;{\rm{othersize}}\; \end{array} \right. $ | (5) |

训练结束时, 每个训练预测框都被标记一个真值类别和真值框的目标位置.

3 实验结果分析 3.1 数据集为了尽可能保证使用大数据量的原始图片进行训练, 本文的原始图像来源于Flickrlogos-32和BelgaLogos数据集, 它们都是互联网上公开的数据集资源.

在使用数据集训练网络前, 为了顺利训练生成对抗网络, 本文先对数据集进行了相应的预处理. 预处理的步骤为: 首先, 选取两个数据集中目标尺寸大于64×64的图片作为高分辨训练样本; 接着, 通过下采样使其尺寸小于32×32, 作为低分辨训练样本. 测试样本从两个数据集中随机选取并不做预处理.

按照上述步骤, 获得训练样本7532张, 测试集4000张. 然后, 按照Pascal VOC 2007的数据格式对获取的训练样本数据集和测试集进行相应的转换工作.

因为Logo的种类众多, 并且获取的每种类别拥有的图片量不一, 有的数量太少不足以用来进行更进一步的细化分类训练. 因此, 所有本文的Logo目标检测只做两类分类和定位, 并不对Logo再细致分类.

3.2 网络参数设置对于Logo检测, 先采用ImageNet大型分类数据集对基础网络做预训练, 获得五层卷积的参数初始化. 除此之外, 网络中添加其它结构均采用“Xavier”[23]进行参数初始化.

整个网络使用随机梯度下降(SGD)训练, 动量为0.9, 权重衰减量为0.0005; 残差块的数量设置为5. 在训练期间, 25%的样本是前景, 剩下的是背景. 预测框与真值框的交并比(IOU)至少0.5.

3.3 方法比较本文方法的测试是在NVIDIA GeForce GTX 1070 GPU和Caffe平台上实现的. 表1显示了本文的方法与其他方法在Logo检测上的平均准确率和召回率的比较. 从数据中, 我们可以明显看出, 改进的方法在检测性能方面优于Faster R-CNN, 说明了我们的改进发挥了作用, 并且因为Fast R-CNN在候选框选取数量远远多于Faster R-CNN, 所以在小物体的检测方面召回率要优于Faster R-CNN. 然而, 在Logo的检测上, 我们的方法依赖于更少的预测框在小物体的检测效果上已经超过了Fast R-CNN, 说明了本文提出的方法在小目标的检测上有优势.

| 表 1 本文方法与Fast R-CNN和Faster R-CNN在Logo测试集上的检测性能比较(%) |

为了分析不同尺度下三种方法的性能, 我们将目标划分为两种类型的尺度: 像素小于32×32小目标和像素大于32×32的中大型目标. 通过Accuracy-Recall曲线比较它们在Logo数据集上的检测性能, 如图5所示. 总的来说, 我们的方法优于其他方法, 特别是在小物体的检测中, 证明了我们方法的有效性. 如图5(a)所示, Fast R-CNN在小目标检测中优于Faster R-CNN. 然而, 当将GAN引入Faster R-CNN时, 改进的Faster R-CNN比Fast R-CNN方法获得更好的性能. 它证明了生成器为小目标创造了适当的偏差, 使小目标的特征与大目标的特征相似, 从而获得了良好的性能. 对于大中型物体检测, 图5中所示的三种方法略有不同. 客观地说, Fast R-CNN的性能比其他两种方法弱. 在测试中型和大型物体时, Faster R-CNN稍微弱于我们的改进方法. 为了更直观显示我们的检测效果, 我们随机选取了几张三种方法在Logo数据集上的检测效果图, 如图6所示. 图6中子图(a)、(b)、(c)分别代表的是Fast R-CNN、Faster R-CNN和改进的方法的检测效果图. 从图中可以看出, 相比于前两种方法, 改进的方法在定位和分类概率上都更加准确.

|

图 5 改进方法与Fast R-CNN和Faster R-CNN的Accuracy-Recall曲线图 |

4 结语

本文将GAN引入Faster R-CNN框架. 我们使用生成网络生成一个特征偏差, 使小目标的特征类似于大目标的特征, 从而欺骗了判别器. 通过这种策略, 与Faster R-CNN相比, 我们的方法有效地提高了小目标的检测性能. 尽管我们的方法使用Logo数据集进行训练和测试, 但是该方法的应用不只限于Logo的检测, 而且还可以用于其他情况下的小目标检测. 当然, 我们需要改进的地方还有很多. 两种模型的组合使网络结构更加复杂, 训练还需要分两个阶段完成, 训练时间和计算量的增加是不可避免的.

|

图 6 改进的方法与Fast R-CNN和Faster R-CNN在测试集的检测效果图 |

| [1] |

Li Z, Schulte-Austum M, Neschen M. Fast logo detection and recognition in document images. Proceedings of the 20th International Conference on Pattern Recognition. Istanbul, Turkey. 2010. 2716–2719.

|

| [2] |

Joly A, Buisson O. Logo retrieval with a contrario visual query expansion. Proceedings of the 17th ACM International Conference on Multimedia. Beijing, China. 2009. 581–584.

|

| [3] |

Doermann DS, Rivlin E, Weiss I. Logo recognition using geometric invariants. Proceedings of the 2nd International Conference on Document Analysis and Recognition. Tsukuba Science City, Japan. 1993. 894–897.

|

| [4] |

Doermann D, Rivlin E, Weiss I. Applying algebraic and differential invariants for logo recognition. Machine Vision and Applications, 1996, 9(2): 73-86. DOI:10.1007/BF01214362 |

| [5] |

Hassanzadeh S, Pourghassem H. A fast logo recognition algorithm in noisy document images. Proceedings of 2011 International Conference on Intelligent Computation and Bio-Medical Instrumentation. Wuhan, China. 2012. 64–67.

|

| [6] |

Girshick R, Donahue J, Darrell T, et al. Rich feature hierarchies for accurate object detection and semantic segmentation. Proceedings of 2014 IEEE Conference on Computer Vision and Pattern Recognition. Columbus, OH, USA. 2014. 580–587.

|

| [7] |

Girshick R. Fast R-CNN. Proceedings of 2015 IEEE International Conference on Computer Vision. Santiago, Chile. 2015. 1440–1448.

|

| [8] |

Ren SQ, He KM, Girshick R, et al. Faster R-CNN: Towards real-time object detection with region proposal networks. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2017, 39(6): 1137-1149. DOI:10.1109/TPAMI.2016.2577031 |

| [9] |

Redmon J, Divvala S, Girshick R, et al. You only look once: Unified, real-time object detection. Proceedings of 2016 IEEE Conference on Computer Vision and Pattern Recognition. Las Vegas, NV, USA. 2016. 779–788.

|

| [10] |

Liu W, Anguelov D, Erhan D, et al. SSD: Single shot MultiBox detector. Proceedings of the 14th European Conference on Computer Vision-ECCV 2016. Amsterdam, The Netherlands. 2016. 21–37.

|

| [11] |

Bell S, Zitnick CL, Bala K, et al. Inside-outside net: Detecting objects in context with skip pooling and recurrent neural networks. Proceedings of 2016 IEEE Conference on Computer Vision and Pattern Recognition. Las Vegas, NV, USA. 2016. 2874–2883.

|

| [12] |

Li HX, Lin Z, Shen XH, et al. A convolutional neural network cascade for face detection. Proceedings of 2015 IEEE Conference on Computer Vision and Pattern Recognition. Boston, MA, USA. 2015. 5325–5334.

|

| [13] |

Yang F, Choi W, Lin YQ. Exploit all the layers: Fast and accurate CNN object detector with scale dependent pooling and cascaded rejection classifiers. Proceedings of 2016 IEEE Conference on Computer Vision and Pattern Recognition. Las Vegas, NV, USA. 2016. 2129–2137.

|

| [14] |

Eggert C, Dan ZC, Brehm S, et al. Improving small object proposals for company logo detection. Proceedings of 2017 ACM International Conference on Multimedia Retrieval. Bucharest, Romania. 2017. 167–174.

|

| [15] |

Li JN, Liang XD, Wei YC, et al. Perceptual generative adversarial networks for small object detection. Proceedings of 2017 IEEE Conference on Computer Vision and Pattern Recognition. Honolulu, HI, USA. 2017. 1951–1959.

|

| [16] |

Goodfellow IJ, Pouget-Abadie J, Mirza M, et al. Generative adversarial nets. Proceedings of the 27th International Conference on Neural Information Processing Systems. Montreal, Canada. 2014. 2672–2680.

|

| [17] |

Mathieu M, Couprie C, LeCun Y. Deep multi-scale video prediction beyond mean square error. arXiv preprint arXiv:1511.05440, 2015.

|

| [18] |

Denton E, Chintala S, Szlam A, et al. Deep generative image models using a Laplacian pyramid of adversarial networks. Proceedings of the 28th International Conference on Neural Information Processing Systems. Montreal, Canada. 2015. 1486–1494.

|

| [19] |

Li C, Wand M. Combining Markov random fields and convolutional neural networks for image synthesis. Proceedings of 2016 IEEE Conference on Computer Vision and Pattern Recognition. Las Vegas, NV, USA. 2016. 2479–2486.

|

| [20] |

Yeh R, Chen C, Lim TY, et al. Semantic image inpainting with perceptual and contextual losses. arXiv preprint arXiv:1607.07539, 2016.

|

| [21] |

Radford A, Metz L, Chintala S. Unsupervised representation learning with deep convolutional generative adversarial networks. arXiv preprint arXiv:1511.06434, 2015.

|

| [22] |

Ledig C, Theis L, Huszár F, et al. Photo-realistic single image super-resolution using a generative adversarial network. Proceedings of 2017 IEEE Conference on Computer Vision and Pattern Recognition. Honolulu, HI, USA. 2017. 105–114.

|

| [23] |

Glorot X, Bengio Y. Understanding the difficulty of training deep feedforward neural networks. Proceedings of the 13th International Conference on Artificial Intelligence and Statistics. Sardinia, Italy. 2010. 249–256.

|

2019, Vol. 28

2019, Vol. 28